8. Intel·ligència artificial i protecció de dades

8.1 Què és la intel·ligència artificial?

Normativament, la intel·ligència artificial (IA) l'ha regulada recentment a Europa el Reglament de la Unió Europea 2024/1689 de 13 de juny, en endavant, RIA (Reglament d'intel·ligència artificial).

El RIA defineix els sistemes d’IA com un sistema basat en una màquina dissenyada per funcionar amb diferents nivells d'autonomia, que pot mostrar capacitat d'adaptació després del desplegament, i que, per a objectius explícits o implícits, infereix de la informació d'entrada que rep la manera de generar resultats de sortida, com ara prediccions, continguts, recomanacions o decisions, que poden influir en entorns físics o virtuals.

Etimològicament, la IA és un concepte compost per dos elements: intel·ligència i artificial.

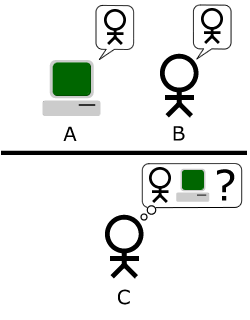

La característica d’artificialitat concorre quan el subjecte és una màquina enlloc d’un ésser humà. No obstant això, és més ambigu i controvertit establir un llindar sobre quan aquesta màquina o dispositiu actua de forma intel·ligent.

Alan Turing va contribuir a resoldre aquest aspecte considerant que un comportament/resultat que oferia una màquina era intel·ligent quan no es podia distingir del comportament o resultat que oferiria un ésser humà.

Això no obstant, aquesta aproximació és encara poc precisa i pot encabir-hi sistemes amb nivells d’intel·ligència molt dispars. Actualment, els sistemes d’IA fan les tasques per a les quals han estat dissenyats, moltes vegades amb una precisió més gran que els experts humans en la matèria. Ara bé, aquests sistemes no tenen utilitat fora de l’àmbit concret per al qual han estat dissenyats; és el que es coneix com a "IA feble".

En contraposició, la IA general es refereix a la capacitat d’un sistema per poder aprendre i portar a terme qualsevol tipus de tasca. En aquests moments encara no s’ha aconseguit aquest nivell de desenvolupament. Si es porta la IA general a l’extrem, es parla de la singularitat: el punt en què la IA superarà les capacitats de la intel·ligència humana i que hipotèticament podria tenir conseqüències imprevisibles.

El RIA pretén configurar una IA centrada en l'ésser humà i fiable, que garanteixi un alt grau de protecció de la salut, la seguretat i els drets fonamentals.

Al mateix temps, la regulació europea de la IA no inclou l'actuació administrativa automatitzada, ja que, com indica el RIA al considerant 12, una característica principal dels sistemes d'IA és la capacitat d'inferència. Aquesta capacitat d'inferència es refereix al procés d'obtenció de resultats de sortida, com ara la capacitat d'inferir o extrapolar conclusions a partir de noves dades o, com diu el RIA, deduir models o algorismes, o ambdós, a partir d'informació d'entrada o dades. En definitiva, enraonar o fer prediccions d'una manera similar a les habilitats humanes.

Per concloure amb l'aproximació conceptual, s'ha de precisar el concepte de sistema d’IA, oposant-lo a un altre concepte, el model d’IA.

La diferència entre un model d'IA i un sistema d'IA rau en l'abast i la funcionalitat:

És un algoritme o conjunt d'algoritmes entrenats per efectuar una tasca específica, com ara, reconeixement d'imatges, processament de llenguatge natural o predicció de dades. Un model d'IA és el nucli matemàtic i estadístic que pren dades d'entrada i genera resultats basats en el seu entrenament.

És un conjunt complet que inclou un o diversos models d'IA juntament amb altres components necessaris per al seu funcionament, com interfícies d'usuari, bases de dades, sensors, mecanismes de control i fluxos de treball. Un sistema d'IA pot integrar models d'IA dins d'una aplicació més àmplia, com un assistent virtual, un sistema de recomanació o un vehicle autònom.

En resum, el model d'IA és la part analítica que aprèn i prediu, mentre que el sistema d'IA és l'aplicació completa que fa servir aquest model en un entorn real.

Igualment, podem definir l’algoritme, terme que a vegades utilitzem de manera indiferenciada en aquest context, però que, atenent que en termes jurídics tots tres conceptes (sistema, model i algoritme) no són el mateix, s’han de precisar.

Els algoritmes són procediments, que es descriuen sovint en llenguatge matemàtic o pseudocodi, que s'apliquen a un conjunt de dades per assolir una funció o un propòsit determinats.

Els models són l'output d'un algoritme que s'ha aplicat a un conjunt de dades.

En termes senzills, un model d'IA s'utilitza per fer prediccions o prendre decisions i un algoritme és la lògica amb què funciona aquest model d'IA.

El RIA és conscient de la importància, en termes de seguretat jurídica, d’entendre i aplicar correctament els conceptes, i a l’extens considerant 97 parla de la diferència entre sistema i model. Reproduïm una petita part que considerem aclaridora: "Encara que els models d'IA són components essencials dels sistemes d'IA, no constitueixen per si mateixos sistemes d'IA. Els models d'IA requereixen afegir-hi altres components, com, per exemple, una interfície d'usuari, per convertir-se en sistemes d'IA. Els models d'IA solen estar integrats en els sistemes d'IA i formar-hi part."

En definitiva, els algoritmes configuren models, i els models s’integren en sistemes que, al seu torn, si són generatius, poden crear i integrar nous models.

8.2 La intel·ligència requereix un aprenentatge previ

8.2.1 Definició bàsica

El comportament “intel·ligent” per part de les màquines és el resultat que proporciona un determinat algoritme –entès com un conjunt de paràmetres– un cop hom el confronta amb una dada o un conjunt de dades o situació concreta.

Però aquest algoritme només pot proporcionar resultats veritablement intel·ligents (indistingibles dels que oferiria un humà) –sobretot si ha d’interactuar en entorns complexos i canviants, ja que és molt difícil anticipar i programar tots els escenaris possibles i les respostes corresponents– si abans ha après adequadament de tal manera que s’han pogut ajustar els pesos i els paràmetres que configuren l’algoritme.

A títol d’exemple, imaginem que volem crear una aplicació d’IA per competir jugant a escacs. Definim matemàticament la posició de les peces, els moviments permesos i la programem de tal manera que aleatòriament executi un moviment cada vegada que sigui el seu torn. És evident que el resultat que proporcionarà no podrà ser qualificat d’intel·ligent atès que es limitaria a seguir unes normes predefinides (no contravenir les regles del joc). Ara bé, si es fa evolucionar aquest algoritme, sigui proporcionant-li un seguit de moviments i els resultats obtinguts en funció de la posició de la resta de peces del contrincant, o bé hom el fa jugar múltiples partides configurant prèviament que si li maten la peça és un factor negatiu i si aconsegueix matar una peça del rival és positiu, l’algoritme quan el confrontem a una nova partida haurà après a anticipar amenaces, a implementar estratègies pròpies de diversos moviments i, sobretot, a ser flexible en funció de la situació de l’oponent (disposició de peces i de cada moviment dut a terme). En termes més matemàtics, haurà incorporat factors que potser abans no tenia en compte, i s'haurà atribuït “pesos” en el sentit de donar importància a cadascun dels seus paràmetres de manera molt acurada (és a dir, el factor positiu per matar una fitxa del contrari que inicialment potser era un factor determinant en si mateix, es veu reduït si aquest moviment implica que aquella peça quedi exposada i la guanyi el rival).

El factor més destacable és que per tal que l’algoritme evolucioni i sigui millor necessita de manera indispensable i crítica tenir accés a dades/informació. I, en termes generals, com més informació hom li proporciona més aprèn i permet generar i fer precisos algoritmes especialment complexos com són les xarxes neuronals amb múltiples capes (que possibiliten el que es coneix com l'aprenentatge profund o deep learning).

En definitiva, el comportament global no és diferent del d’una persona, ja que l’aprenentatge requereix indefectiblement que ens proporcionin informació sigui experimental o bé a través de mitjans de transmissió escrita com llibres. I com més experiències i inputs d’informació rebuts, en principi serem capaços de mostrar un comportament més intel·ligent.

De fet, els líders en el desenvolupament de la IA com és el cas d'Oriol Vinyals, expliquen que la clau del salt qualitatiu que està experimentant aquest camp no és el del disseny algorítmic sinó la possibilitat de millorar aquests algoritmes a través de l'exposició a grans conjunts de dades. La disponibilitat de les dades és, doncs, el factor més crític per al desenvolupament de la IA. El boom que s’està experimentant actualment s'explica per una abundància d’informació com mai s’ha generat, a partir d’una societat cada vegada més digital.

Això en cap cas vol dir que l'aplicació dels sistemes d'IA en camps com els de la investigació no sigui extraordinària i resolgui aspectes d’extrema complexitat. Succintament, podem apuntar per exemple que cal dissenyar adequadament els models, ja que com més complexos –més paràmetres–, a priori, més capacitat per aprendre. Ara bé, si es dissenya un model algorítmic molt precís per resoldre un determinat problema específic és possible que llavors aquest mateix model no sigui útil per donar una resposta satisfactòria a problemes similars. A l’hora de fer aquesta tria, cal tenir en compte dos problemes potencials: l'underfitting (subajustament) i l'overfitting (sobreajustament). Underfitting fa referència a un model que no és prou complex per modelar la relació entre entrades i sortida. Overfitting fa referència a la situació contrària: un model massa complex que, en comptes de modelar la relació entre entrades i sortides generals, captura bàsicament les especificitats de les dades d’entrenament.

Per això, abans d’aplicar el sistema, cal validar que funciona com s’espera sobre casos diferents dels de les dades d’entrenament, que habitualment es fa dividint les dades en un conjunt d’entrenament i en un altre de test. El model s’ajusta a les dades d’entrenament i posteriorment es valida la precisió que ha tingut sobre les dades de test.

8.2.2 Diferents mètodes per a l'aprenentatge

Malgrat que les dades sempre són el factor clau, existeixen diferents estratègies per aconseguir que els algoritmes aprenguin, també en funció de si les dades han estat prèviament tractades/etiquetades –aprenentatge supervisat–, són subministrades en brut o generades artificialment –per la identificació de patrons de manera no supervisada– o bé són autogenerades a partir de la interacció entre un agent autònom i l’entorn –aprenentatge per reforç.

En l’aprenentatge supervisat es dona al sistema unes dades d’entrenament amb uns valors d’entrada i uns de sortida; en diem "dades etiquetades". L’objectiu és que el sistema aprengui la relació entre valors d’entrada i de sortida.

En l’aprenentatge no supervisat el sistema aprèn relacions a partir de dades que no han estat etiquetades prèviament. Amb aquest tipus de dades el sistema pot aprendre patrons, zones on hi ha més concentració de punts, etc.

Per exemple, si tenim dades de les compres dels clients d’un supermercat, el sistema podria aprendre quins tipus de productes s’acostumen a comprar conjuntament. Aquesta informació la pot explotar el supermercat de diverses maneres: per distribuir els productes al supermercat de manera que s’incrementin les vendes, per enviar-nos ofertes sobre productes relacionats amb el nostre cistell de consum, etc.

L’aprenentatge per reforç s’utilitza per entrenar agents intel·ligents. Amb el terme "agent" fem referència al fet que el sistema que percep l’entorn pren accions i veu quin és el resultat (premi o càstig) d’aquestes accions.

Per exemple, continuant amb l’exemple dels escacs, el sistema és capaç de percebre l’estat actual (la posició de les peces al taulell), pot moure una peça (perquè coneix les regles dels escacs) i veu quin és el resultat del moviment (pot determinar quan s’ha guanyat o s’ha perdut, però també si un conjunt de moviments ens apropa a un estat més o menys desitjable).

Durant l’aprenentatge per reforç, l’agent va explorant les diverses accions que es poden prendre en cada estat concret i ajusta la preferència que s’hi assigna segons com sigui de desitjable el resultat que s’obté en aplicar-les (AlphaZero).

En tot cas, un dels camps més rellevants en les investigacions que es duen a terme és l’àmbit de com fer aprendre. Així, més enllà d’aquesta primera aproximació més basada en les dades, s’utilitzen mecanismes que permeten optimitzar aquest procés feixuc.

Per exemple, sovint (sobretot en els camps del processament del llenguatge natural) s’utilitzen transformers que el que fan és principalment adaptar l’atenció del procés d’aprenentatge de tal manera que si les dades que s’introdueixen són una frase, el sistema ho processa de manera conjunta i no paraula per paraula —aproximació que li permet comprendre molt millor el significat. De fet, aquest tipus d’innovació ha fet possible l’aparició d’algunes de les solucions d’IA generativa que s’abordaran a l’apartat següent, com és el ChatGPT. De fet, GPT és la sigla de "Generative Pre-trained Transformer”, ja que tècnicament es basa en un sistema que genera contingut basant-se en un model d’atenció prèviament entrenat amb grans volums d’informació disponible a la xarxa, com pot ser la Viquipèdia.

8.3 El gran potencial de la intel·ligència artificial: l'exemple de la intel·ligència artificial generativa

Un cop els algoritmes estan suficientment i adequadament entrenats, poden oferir resultats molt atractius en relació amb multitud de tasques.

Inicialment, aquestes funcions se circumscrivien principalment a la presa de decisions (moviments en videojocs, conducció de vehicles autònoms, detecció de frau o de correu escombraries, identificació de faltes d’ortografia, traducció de textos en el sentit de correspondència d’informació, etc.). En tots aquests camps les aplicacions basades en IA ja han demostrat com a mínim que han igualat i fins i tot han superat els humans.

Ara bé, recentment han aparegut múltiples aplicacions basades en IA que han posat en relleu que ja és possible gairebé igualar els humans en una tasca com és la creació/generació de nou contingut.

El màxim exponent d’aquesta nova onada d’innovació en l’àmbit de la IA, la constitueixen els bots de conversa, col·loquialment anomenats "xatbots". La definició clàssica de bot de conversa és un programa d'IA que processa missatges en llenguatge natural emesos per l'usuari a través de sistemes de teclat o àudio i que genera respostes que són enviades de nou a l'usuari, amb l'objectiu de simular una conversa real entre dos humans.

També es denominen "assistents virtuals" o "assistents personals" quan permeten una interacció detallada i atenta a les necessitats particulars de cada usuari. Quan l'objectiu final d'aquests programes és donar resposta a dubtes i/o sol·licituds respecte a un tema específic sense necessitat que existeixi un intermediari humà, es denominen “assistents virtuals”. És el cas del ChatGPT (d’OPENAI), a què s'estan afegint altres solucions com Google Gemini o la xinesa DeepSeek. Tot i això, hi ha moltes altres aplicacions que comparteixen la possibilitat de creació de contingut no només textual sinó també gràfic com DALL-E, Stable Diffusion o Midjourney. Això al marge de la utilització, cada vegada més freqüent, dels sistemes d'IA en àmbits com el de l'assistència sanitària, la recerca, la seguretat i, fins i tot, en el funcionament de les administracions públiques, com pot ser la gestió de les ciutats intel·ligents (smart cities).

En definitiva, el potencial de la IA és difícilment delimitable. I, en correlació amb aquesta circumstància, els avantatges en termes d'innovació i competitivitat són innegables, però no es poden deixar de banda que hi ha pràctiques d’IA prohibides, com la possibilitat que sistemes d’IA utilitzin tècniques manipuladores del comportament de les persones; explotin les vulnerabilitats de determinats col·lectius per raó de la seva edat o discapacitat; prediguin que, per raó del teu perfil, és més probable que puguis cometre un delicte; infereixen les teves emocions en el lloc de treball, o, per raó de la teva categorització biomètrica, en dedueixen la raça, l'opinió política o l'orientació sexual, entre altres pràctiques prohibides.

Igualment, hem de tenir presents els riscos que es deriven de la utilització de la IA.

8.4 Riscos dels sistemes d'intel·ligència artificial

Quan parlem d'IA els riscos en relació amb la protecció de dades augmenten. Els riscos que es poden destacar són els següents:

1. Opacitat en la presa de decisions (caixes negres)

Els processos de decisió dels sistemes d'IA han de ser transparents i explicables i, en aquest sentit, cal avaluar si la programació o el funcionament de l’algoritme és correcte. Aspecte tecnològic que, en termes de prova tecnològica, planteja una gran complexitat.

2. Discriminació algorítmica i estupidesa artificial

Es planteja igualment que els processos de configuració de l’algoritme, en funció del disseny i les condicions de recollida de les dades, plantegin biaixos que posteriorment, amb la posada en funcionament del sistema, generin discriminacions o resultats arbitraris, fins i tot absurds.

En aquest sentit, es poden produir resultats esbiaixats, sortides d’IA distorsionades que perjudiquin el destinatari de la decisió, derivades d’errors en el tractament de la informació, al marge que es poden produir problemes ètics o de discriminació.

Fins i tot, els sistemes d’IA poden arribar a fabricar fortuïtament informació que pot comportar problemes seriosos si no es fa una acurada supervisió humana (és la coneguda "al·lucinació de la màquina"), que pot produir informació de poca qualitat i derivar en una manca de confiança en els sistemes.

3. Predictibilitat preventiva

Un dels grans reptes o límits el trobem en la predictibilitat preventiva, la possibilitat dels sistemes d’IA d’interpretar o deduir conductes futures, que podria afectar de manera significativa la llibertat de l’individu.

El RIA es preocupa d’aquest extrem i prohibeix a l’article 5.1 una sèrie de pràctiques d’IA. En concret, quant a la predictibilitat preventiva, la lletra d prohibeix la introducció en el mercat, la posada en servei per a aquest fi específic o l'ús d'un sistema d'IA per dur a terme avaluacions de riscos de persones físiques per tal de valorar o predir el risc que una persona física cometi un delicte.

4. Precaució algorítmica

Un dels principis bàsics a l’hora de prendre decisions, és el principi de precaució, que determina que, davant de la possibilitat que una actuació pugui produir un dany, en relació igualment al principi de proporcionalitat, no s’adopti una determinada mesura.

Aquest principi, plenament integrable en els processos de decisió humana i la discrecionalitat de la decisió, no són fàcilment traslladables entorn de la IA, que, en principi, no pensa.

Autors com Ponce Solé s’hi han pronunciat en els termes següents (la traducció és nostra):

“En tot cas, en espera de poder avançar, potser, en un dilema que ha ocupat ments brillants durant segles, i aplicant aquí més que les metàfores de la física newtoniana les pròpies de la física quàntica de la nostra època, la incertesa que envolta encara la possibilitat de replicar una consciència humana i una empatia emocional equivalent en la IA ens porta a proposar l'aplicació jurídica del principi de precaució per prevenir els greus riscos amb què ens enfrontem (màquines adoptant decisions automatitzades discrecionals que han d'implicar drets d'humans).”

5. Reserva d’humanitat (ètica)

En connexió amb l’anterior, s'ha d’avaluar igualment el vessant ètic de la decisió, és a dir, fins a quin punt es poden introduir aquests aspectes en les decisions a prendre, com a mesura de protecció dels individus davant decisions adoptades per sistemes d’IA.

6. Riscos de vulneració de la normativa de protecció de dades

Els sistemes d’IA poden comportar riscos a la privacitat, processant i analitzant dades personals sense el consentiment i prou salvaguardes o, en general, sense l’existència de bases legitimadores que n'habilitin la recollida i el tractament. A més, els resultats de sortida dels sistemes d’IA generativa i els models d’IA poden arribar a identificar individus combinant fonts de dades múltiples.

7. Riscos de seguretat

Finalment, no es pot deixar de banda la seguretat, la possibilitat que els sistemes d’IA siguin objecte d’atacs per prendre el control dels sistemes informàtics, revelar informació sensible, o provocar-ne un mal funcionament. Pensem, per exemple, en la possibilitat que els ciberatacants manipulin conjunts de dades d'informació, explotant vulnerabilitats informàtiques, que determinin que els resultats de sortida dels sistemes d’IA no siguin veraços.

8.5 La protecció de dades personals i la intel·ligència artificial

La incorporació dels sistemes d'IA comporta i ha de comportar un canvi substancial en la nostra societat, si bé cal ponderar acuradament els riscos que es poden derivar de la utilització d'aquesta tecnologia. Al mateix temps, s'ha de cercar la conciliació que s’ha de produir entre la protecció dels drets fonamentals i la innovació, al marge d’altres qüestions com la protecció del medi ambient o l’impuls de l’ocupació.

La referència a una IA centrada en l’ésser humà i fiable seria el nucli essencial del que ha d’implicar establir controls per al desenvolupament i l'ús de sistemes d’IA, especialment pel que fa a la transparència i l'explicabilitat dels resultats de sortida dels sistemes d'IA.

En qualsevol cas, cal precisar que una IA centrada en l'ésser humà implica un enfocament de desenvolupament i d’aplicació d'IA que prioritza les necessitats, els valors i el benestar de les persones, per garantir que la tecnologia no només sigui eficient i avançada, sinó també ètica, equitativa i beneficiosa per a la societat. Aquest enfocament implica dissenyar sistemes d'IA que treballin en col·laboració amb els humans, millorant-ne les capacitats en lloc de reemplaçar-les. L’objectiu és una IA que sigui transparent, comprensible i confiable, que permeti que els usuaris en comprenguin les decisions i en puguin fer un ús informat.

Un aspecte clau de la IA centrada en l'ésser humà és l'ètica. És fonamental garantir que els algoritmes siguin justos i no perpetuïn biaixos discriminatoris. A més, cal prioritzar la privadesa i la seguretat de les dades personals i assegurar que la informació dels usuaris es manegi de manera responsable i amb el seu consentiment.

El desenvolupament de la IA també ha de promoure l'accessibilitat i la inclusió. La tecnologia ha de poder ser utilitzada per totes les persones, independentment de les seves habilitats o condicions socioeconòmiques. Això implica dissenyar interfícies intuïtives i adaptar els sistemes a les necessitats de diferents grups poblacionals.

És igualment important destacar que el RIA no desplaça la normativa de protecció de dades. El considerant 10 així ho disposa:

“El presente Reglamento no pretende afectar a la aplicación del Derecho de la Unión vigente que regula el tratamiento de datos personales, incluidas las funciones y competencias de las autoridades de supervisión independientes competentes para vigilar el cumplimiento de dichos instrumentos. Tampoco afecta a las obligaciones de los proveedores y los responsables del despliegue de sistemas de IA en su papel de responsables o encargados del tratamiento de datos derivadas del Derecho de la Unión o nacional en materia de protección de datos personales en la medida en que el diseño, el desarrollo o el uso de sistemas de IA impliquen el tratamiento de datos personales. También conviene aclarar que los interesados siguen disfrutando de todos los derechos y garantías que les confiere dicho Derecho de la Unión, incluidos los derechos relacionados con las decisiones individuales totalmente automatizadas, como la elaboración de perfiles.”

Al mateix temps, s'ha de tenir present que, avui, el big data i la IA han canviat les regles del joc. Es tracta de tecnologies diferents, però són interdependents, ja que la combinació de les dues fa que la segona desplegui la seva potencialitat al màxim, no tan sols quant als resultats de sortida, sinó també quant a la possibilitat d’identificar i perfilar les persones.

Ens trobem davant del següent estat evolutiu de la innovació tecnològica i, com indiquen autors com Valero Torrijo:

“Doncs bé, certament, aprofitant les possibilitats del big data, però, a més, la capacitat d'aprenentatge autònom que permet la tecnologia actual, ens trobem davant d'un canvi qualitatiu molt destacat, ja que permet en molts casos fer el salt des de la simple anàlisi a la potencial decisió sense intervenció directa d'una persona humana, i fins i tot a la formulació de previsions, amb la capacitat addicional de reconfiguració dels criteris si es detectés algun tipus d'error o desviació. No es tracta, doncs, de noves solucions als problemes actuals sinó, per contra, de noves metodologies que permeten afrontar la presa de decisions des de paràmetres més refinats i, almenys potencialment, també més precisos, però també més invasius.”

Tal com s’ha exposat, en la fase de desenvolupament d’una solució basada en IA es tracten dades, i en el seu funcionament ordinari també, ja que perquè la solució pugui ser operativa cal subministrar-li noves informacions de tal manera que les processi mitjançant l’algoritme corresponent i proporcioni el resultat “intel·ligent” esperat. En principi, aquestes dades no són necessàriament dades de caràcter personal, però això no sempre passa.

En el supòsit que alguna d’aquestes informacions siguin sobre una persona física identificada o identificable, s’estaran tractant dades personals. En concret, són dades personals, entre d'altres, el nom, un número d’identificació, dades de localització i altres dades que a priori potser no s’està acostumat a considerar personals, com ara dades de consum elèctric (segons la STS de 12 de juliol de 2019).

En el cas que es tractin dades de caràcter personal, la normativa de protecció de dades i les competències de les autoritats de control en matèria de protecció de dades, són plenament aplicables.

Així mateix, cal assenyalar que hi ha una tipologia de dades que són les que es consideren “categoria especial”, que correspon a les que revelen l'origen ètnic o racial, les opinions polítiques, les conviccions religioses o filosòfiques o l'afiliació sindical, i que comprenen també les dades genètiques, les dades biomètriques destinades a identificar de manera unívoca una persona física i les dades relatives a la salut, la vida sexual o les orientacions sexuals d'una persona física. Les dades personals de categoria especial gaudeixen d’una protecció reforçada.

A l'últim, cal tenir present l’existència d’un component dinàmic en la determinació de si una dada concreta és personal o no. Així, en la mesura que una dada és personal quan és possible atribuir-la a una persona física o identificable, l’evolució de la tecnologia pot fer que una dada que en un moment determinat no era possible atribuir-la a una persona física en concret, posteriorment, sí que ho sigui. Com hem dit abans, la interacció de la IA amb el big data fa que els riscos d'identificabilitat i afectació a la nostra privacitat es multipliquin exponencialment.

Avaluació d’impacte de protecció de dades (AIPD)

La IA es considera una tecnologia innovadora (emergent), i, de manera inherent a aquesta condició, la seva utilització comporta riscos derivats d’aquesta falta de maduresa.

Abans ens hem referit al fet que la normativa d'IA no desplaça el RGPD quan es tractin dades de caràcter personal. Al mateix temps, el RIA es preocupa per la protecció dels drets fonamentals, entre els quals hi ha el respecte a la protecció de dades de caràcter personal i, amb aquesta finalitat, l'article 27 del RIA estableix efectuar una avaluació d'impacte de drets fonamentals, en relació amb determinats sistemes d'IA d'alt risc, que apareixen enumerats a l'annex III del RIA.

Aquesta avaluació s'ha de relacionar amb l'avaluació d'impacte de protecció de dades de l'article 35 del RGPD.

El dret a la protecció de dades determina (art. 35 del RGPD), que, en particular, quan s’utilitzen noves tecnologies per dur a terme un tractament de dades del qual sigui probable que es pugui derivar un elevat risc per als drets i les llibertats de les persones físiques, amb caràcter previ a iniciar aquest tractament el responsable ha de fer una avaluació de l’impacte de protecció de dades (AIPD). En la mateixa línia, el RIA estableix l'obligació que es dugui a terme una avaluació d'impacte en relació amb determinats sistemes d'IA d'alt risc (art. 27 del RIA). De conformitat amb l'apartat primer de l'article 6 del RIA, un sistema d’IA es considera d’alt risc quan estigui destinat a ser utilitzat com a component de seguretat d’un producte que entri en l’àmbit d’aplicació dels actes legislatius d’harmonització de la Unió o que el producte del qual el sistema d’IA sigui component de seguretat, o el sistema d’IA mateix com a producte, hagi de sotmetre’s a una avaluació de conformitat de tercers per a la seva introducció en el mercat o posada en servei d’acord amb els actes legislatius d’harmonització de la UE. Així mateix, també es considera un sistema d'IA d'alt risc si es correspon amb algun dels àmbits previstos a l'annex III del RIA: biometria, infraestructures crítiques -no està sotmès a l'obligació d'avaluació d'impacte de l'article 27 del RIA-, ensenyament i formació professional, ocupació i gestió dels treballadors, accés a serveis públics o privats essencials, garantia del compliment del dret, migració, administració de justícia i processos democràtics.

Tal com indica l'article 27.4 del RIA, en cas que s'hagi fet prèviament l'avaluació d'impacte de protecció de dades de l'article 35 del RGPD, l'avaluació d'impacte de drets fonamentals la complementa. En definitiva, es tracta d'una relació de complementarietat, sens perjudici que, en principi, la segona té un abast més ampli des del punt de vista d'anàlisi dels drets afectats.

El procés per dur a terme una anàlisi d’impacte consisteix, en un primer moment, a definir les dades que seran objecte de processament, el nombre de subjectes afectats pel processament, la font de les dades i fins a quin punt els ciutadans són coneixedors del tractament. En general, cal conèixer el conjunt de circumstàncies del processament per poder identificar adequadament el risc que implica.

Els riscos no queden delimitats a l’àmbit de les dades personals, sinó que s’ha d’interpretar com qualsevol impacte negatiu en termes de drets i llibertats.

A títol d’exemple, en el cas de la IA cal determinar si hi ha riscos de discriminació en els resultats que es derivin del tractament.

Un cop identificats aquests riscos, cal preveure mecanismes adequats que en permetin la gestió/mitigació. Aquestes mesures poden ser coincidents amb les mesures de seguretat que recull, per exemple, l'Esquema Nacional de Seguretat (d'ara endavant, ENS). En qualsevol cas, cal tenir present que les mesures que a partir de l’avaluació d’impacte de protecció de dades es considerin necessàries s’han d’aplicar amb independència que l’ENS no les fes exigibles a partir de la categoria/importància del sistema al qual s’han d’aplicar (art. 3 de l'ENS).

En el supòsit que de l’avaluació d’impacte de protecció de dades es desprengui que el tractament pot comportar un elevat risc per als drets i les llibertats si el responsable no adopta mesures per mitigar-lo, el responsable necessàriament ha de consultar l’autoritat de control (ex article 36 del Reglament 679/2016) amb caràcter previ a iniciar-lo, i l’autoritat de control pot exigir noves mesures o reconfiguracions del tractament o, fins i tot, concloure que no es pot dur a terme.

A fi de facilitar la confecció de l'avaluació d'impacte en drets fonamentals, l'APDCAT ha fet públic el Model per a l'AIDF: guia i casos d'ús en línia amb el que estableix el nou RIA. En concret, el document ha estat confeccionat pel grup de treball de DPD en xarxa, liderat per l'expert Alessandro Mantelero.

Licitud, limitació de la finalitat i lleialtat

Derivat del gran potencial de les dades (i en particular de les dades personals) hi ha un elevat desig, en especial d’entitats que empren tecnologies emergents i IA, per recopilar i tractar dades personals.

Ara bé, per poder recopilar i tractar dades personals és necessari que concorri una de les condicions de licitud establertes per l’article 6 del RGPD i, en cas que es tracti de dades de categoria especial, a més, cal que hi hagi una de les circumstàncies incloses a l’article 9.2.

Amb caràcter previ a la determinació de la licitud, cal haver definit de manera adequada i precisa la finalitat perseguida amb el tractament, en tant que resulta imprescindible per poder establir quina o quines bases de licitud poden fonamentar el tractament. Aquesta tasca de definició de la finalitat constitueix un repte particularment rellevant en el marc de les tecnologies emergents i la IA, atès que, d'una banda, el conjunt de dades pot ser emprat per a múltiples finalitats i, de l'altra, les tecnologies emergents i la IA també es caracteritzen per l'aplicació potencial a múltiples àmbits.

En concret, la dificultat de determinar l’objectiu perseguit és més elevada quan s’utilitzen algoritmes que s’entrenen en un entorn d’aprenentatge no supervisat i extreuen informació de les dades (patrons, correlacions, etc.), ja que, atès que aquesta informació no es coneix per avançat, es pot posar en dubte si es compleix la limitació de finalitat que difícilment s'haurà pogut determinar amb precisió.

Un altre supòsit especialment sensible des de l’òptica de la protecció de dades consisteix en la reutilització de les dades recollides per part d’un altre agent econòmic amb una finalitat diferent de la que inicialment va permetre obtenir aquella informació. Es tracta d’una situació que contravindria diferents principis, com ara el de la licitud, el de la limitació de la finalitat i el de la lleialtat, de manera que, malgrat els avantatges evidents que podria comportar per a les corporacions, no seria possible en termes generals.

I és que, tot i la versatilitat de les dades i de les tecnologies per explotar-les, cal ser precís en la determinació de la finalitat perseguida, una precisió que, a més –en virtut del principi de lleialtat i de limitació de la finalitat–, cal que es mantingui a cada moment; és a dir, l’ús que es fa de les dades ha de ser previsible per als ciutadans a cada moment. Per tant, qualsevol modificació requereix que es replantegi integralment la base de licitud que justifica el tractament i que es comuniqui adequadament als titulars de les dades.

Val a dir que en l’apartat b in fine de l’article 5 hi ha una excepció a aquesta limitació de la finalitat quan la “nova” finalitat que es vol dur a terme consisteix en una finalitat de "recerca científica o històrica, o amb finalitat estadística”, i en el considerant 159 del RGPD s’assenyala que el concepte de "recerca científica” s’ha d’interpretar de manera àmplia, de tal manera que, per exemple, comprèn “el desenvolupament tecnològic i la demostració, la recerca fonamental, la recerca aplicada i la recerca finançada pel sector privat”. En conseqüència, es podrien reutilitzar dades, per exemple, en l’àmbit de la IA si es pot sostenir de manera reeixida que la tasca que es vol dur a terme és assimilable al concepte de "recerca científica”.

Minimització

El principi de minimització determina que les dades utilitzades en un tractament han de ser adequades, pertinents i limitades al que és estrictament necessari per assolir la finalitat del tractament.

Particularment en l’àmbit de la IA, l’aplicació d’aquest principi és especialment delicat, ja que un funcionament adequat de la IA depèn en gran manera de les dades que es proporcionen al sistema per ser entrenat. Així, a priori, com més volum de dades millor ha pogut aprendre el sistema i, per tant, més fiables/acurades són les seves previsions.

Per tant, disminuir el volum de dades per sota d’un determinat nivell pot implicar una relativa pèrdua en termes de precisió estadística i pot comportar que apareguin uns certs biaixos i discriminacions que, en el marc d’un elevat volum de dades, quedin diluïts.

Tot i això, aquesta reflexió no implica de cap manera que no s'hagi d’aplicar el principi de minimització, sinó que el repte és trobar el punt d’equilibri adequat en termes de protecció de dades i de funcionament adequat de la IA, de tal manera que es pugui concretar que únicament es poden recopilar i tractar les dades que es considerin indispensables.

Per valorar adequadament aquesta “necessitat” o “indispensabilitat” és imprescindible tenir clarament definida la finalitat perseguida, ja que l’anàlisi consisteix precisament a contraposar les dades en relació amb l’objectiu a assolir i, en concret, preguntar-se si la informació és necessària o indispensable per poder-ho aconseguir. Ara bé, tal com s’ha apuntat prèviament, la determinació de la finalitat és particularment complexa atesa la versatilitat de les dades i de les tecnologies emergents (i la IA).

Des d’un punt de vista tècnic, hi ha diverses tècniques que permeten reduir o minimitzar l’ús de dades personals, però en destaca l’ús de dades sintètiques (dades artificials que reprodueixen les característiques de les dades originals) o dades anonimitzades (dades en què s’ha trencat l’enllaç amb la persona que les ha originades). En tots dos escenaris la implantació de les tècniques indicades possibilita dur a terme el processament de dades sense ni tan sols utilitzar dades personals, ja que en ambdós casos no hi ha vincle entre la informació i les persones concretes.

Dret a la intervenció humana

Algunes aplicacions prenen decisions fent ús d’IA.

Així, per exemple, es poden utilitzar sistemes d'avaluació (scoring) de crèdit per determinar la concessió o no d’un crèdit o emprar sistemes de classificació automàtica per preseleccionar candidats per a un determinat lloc de feina.

Emprar algoritmes per prendre decisions com a substitut de raonaments humans implica un cert risc inherent propi de l’ús de tecnologies emergents i, en particular, en el cas de la IA, de garantir que els resultats són adequats (algoritmes prou entrenats i generals per ser aplicables a diferents supòsits) i que no responen a biaixos o discriminacions. Hi ha diverses circumstàncies que poden comportar que la implementació d’aquest tipus de solucions comportin discriminacions, essencialment: dades d’entrenament esbiaixades o desequilibrades i l'ús d’un model d’IA inadequat. Fins i tot si es fes tot bé, seria poc probable que tothom considerés que el sistema funciona adequadament. El problema principal és que cada part interessada pot tenir un concepte diferent sobre l’equitat i no és possible satisfer totes les visions alhora.

El sistema de predicció de reincidència criminal COMPAS il·lustra aquesta dificultat. L’objectiu de Northpointe, el desenvolupador, és obtenir la màxima precisió i entrenar el sistema perquè no hi hagi biaix estadístic (d’un grup de persones classificades amb un tant per cent de risc de reincidència, reincideixen exactament el tant per cent de persones). D’altra banda, ProPublica argumenta que COMPAS discrimina perquè la taxa de falsos positius és el doble per a les persones negres; és a dir, que les persones negres que no reincideixen tenen gairebé el doble de probabilitats de ser classificades erròniament com d'alt risc. Aquest tracte diferencial es produeix encara que la raça no s'inclou entre els atributs que tracta COMPAS. El problema és que són dos objectius incompatibles, i evitar el tracte diferencial condueix a una reducció en la precisió del sistema. El compromís que ha d’adoptar el sistema és, per tant, una qüestió que s’ha d’abordar des d’un punt de vista ètic, tenint en compte els drets de les persones afectades.

A més, l’ús de sistemes automatitzats implica la inexistència d’intervenció humana, circumstància que, al seu torn, impossibilita a la persona afectada la decisió d’efectuar un raonament per rebatre-la. Sovint, ni tan sols és possible conèixer detalladament com el sistema de decisió automatitzada ha arribat a aquella decisió (no és explicable).

En atenció a aquesta circumstància, l’article 22 del RGPD estableix el dret “a no ser objecte d’una decisió basada únicament en el tractament automatitzat, incloent-hi l’elaboració de perfils, que produeixi efectes jurídics en ella o l’afecti significativament de manera similar”; és a dir, en els casos que la decisió automatitzada comporti efectes significatius per a les persones cal que hi hagi intervenció humana.

Dret a la transparència

Tot i que sovint s’indica que l’article 22 ofereix protecció específica davant de decisions automatitzades, cal no ometre altres proteccions que també es projecten enfront d’aquest tipus de decisions, com són les que deriven dels principis de protecció de dades (art. 5 del RGPD) i, entre aquests, el primer que estableix el principi de transparència en relació amb l’interessat (que es desenvolupa als articles 13 i 15).

La transparència és un dels pilars bàsics del dret a la protecció de dades, ja que es tracta d’una condició necessària perquè els ciutadans puguin exercir els drets, ja que si no coneixen a quins tractaments són sotmeses les seves dades no poden, per exemple, oposar-s’hi.

Aquest principi pren una rellevància especial en l’àmbit de l’aplicació d’algoritmes que prenen decisions, fins i tot quan a priori no tenen efectes jurídics per als ciutadans. El motiu és que l’asimetria informativa entre els usuaris i el funcionament de l’algoritme és molt significativa.

Actualment, la complexitat dels models més utilitzats fa que no sigui possible donar una explicació sobre un resultat concret; per exemple, hi ha models basats en aprenentatge profund que utilitzen bilions de paràmetres. Davant la incapacitat d’entendre el funcionament d’aquests sistemes tan complexos, es diu que funcionen com una caixa negra: sabem l’entrada i la sortida, però no com es genera la sortida a partir de l’entrada.

Aquesta asimetria informativa també va ser evident per Sergey Brin i Lawrence Page (creadors de Google): en el document o la comunicació on van presentar Google van dedicar l’apèndix A a advertir sobre els riscos derivats del fet que, fins i tot per als experts, resultava extremadament difícil poder determinar quan un cercador tenia un biaix, de tal manera que qui gestionés el cercador podria, per exemple, decidir no publicar una notícia dels riscos d’utilitzar el telèfon mòbil mentre es condueix perquè un dels seus anunciants és una important companyia de telefonia mòbil, i ometre la informació o relegar-la a posicions més amagades en els resultats mostrats.

També prenent en consideració aquesta circumstància, el RGDP conté diverses determinacions relatives a la transparència en la presa de decisions automatitzades. Ja al considerant 71 es reconeix el dret a “rebre una explicació de la decisió adoptada” i als articles 13.2.f i 14.2.g, el dret a obtenir la informació significativa sobre la lògica aplicada així com la importància i les conseqüències previstes del referit tractament per a l’interessat. Tot i que, com s’ha assenyalat, explicar adequadament la lògica que ha conduït a adoptar una decisió automatitzada és particularment complex.

A l'últim, cal indicar que el Future of Privacy Forum ha fet públic un estudi sobre la jurisprudència rellevant en relació amb la presa de decisions automatitzades, en el qual, entre altres aspectes, s’analitzen els llindars per a l’aplicabilitat de l’article 22 del RGPD en el sentit d’interpretar quan una decisió es basa únicament en criteris automatitzats i quan es considera que la decisió comporta efectes jurídics o una afectació significativa de manera similar.

El conjunt de principis de la protecció de dades

Tot i les cinc mesures de protecció en l’àmbit de protecció de dades que es consideren especialment destacables, cal no obviar el conjunt de principis que determinen com cal dur a terme un tractament de dades personals, que també s’erigeixen en elements de protecció envers els titulars d’aquestes dades.

A més, cal tenir en compte que, d’acord amb la noció de la protecció de dades des del disseny i per defecte, és imprescindible garantir en tot moment –ja des del disseny de l’aplicació– la satisfacció de les obligacions que dimanen dels principis relatius al tractament que estan recollits expressament a l’article 5 del RGPD. En concret, partint d'aquests principis, les dades personals han de ser:

- a. Tractades de manera lícita, lleial i transparent en relació amb l'interessat (“licitud, lleialtat i transparència”).

- b. Recollides amb finalitats determinades, explícites i legítimes i posteriorment no s’han de tractar de manera incompatible amb aquestes finalitats (“limitació de la finalitat”).

- c. Adequades, pertinents i limitades a allò que és necessari en relació amb les finalitats per a les quals es tracten (“minimització de dades”).

- d. Exactes i, si cal, s’han d’actualitzar (“exactitud”).

- e. Conservades de manera que permetin identificar els interessats durant un període no superior al necessari per a les finalitats del tractament de dades personals (“limitació del termini de conservació”).

- f. Tractades de manera que se’n garanteixi una seguretat adequada (“integritat i confidencialitat”).

Precisament el pretès incompliment d’aquests principis per part de la coneguda aplicació ChatGPT d’Open AI és el que ha conduït recentment a l’autoritat de protecció de dades italiana a determinar la suspensió d’aquest servei en territori italià i ha propiciat la creació d’un grup de treball per part de l’European Data Protection Board, que l’Autoritat Espanyola de Protecció de Dades hagi obert una investigació i que l'Autoritat Catalana de Protecció de Dades hagi recomanat que no s'incorpori l'aplicació ChatGPT en la prestació de serveis públics quan es tractin dades personals.

Les transferències internacionals de dades

En relació directa amb alguns dels principis anteriors -com el de transparència-, convé prendre en consideració que l'ús de sistemes d'IA comporten sovint que el processament de dades que els proporcionem i que es processen en una ubicació geogràfica pot no estar prèviament definida clarament.

Així doncs, no és descartable que almenys en alguns casos les dades que subministrem a aquests sistemes acabin fora de la Unió Europea, de tal manera que serien aplicables les previsions corresponents a les transferències internacionals de dades (article 44 i següents del RGPD), doncs únicament estan permeses les transferències de dades personals si concorren determinats supòsits en la mesura que es considera que cal garantir que l'estat destinatari de les dades tingui un estàndard similar a l'europeu en termes de protecció de les dades personals.

Per aquest motiu, l'aparició recent de xats basats en IA confeccionats a l'Àsia constitueixen un repte rellevant per fer-ne compatible l'ús amb la regulació vigent de protecció de dades europea.

8.6 Consideracions finals. La protecció de dades: la millor protecció davant dels riscos que planteja la intel·ligència artificial

El rendiment potencial en termes d’utilitat i innovació que ofereix la IA és de tal magnitud que resulta difícilment resistible. D'altra banda, els avantatges en la seva utilització també són una realitat tangible.

No obstant això, s’ha d’evitar que aquest atractiu impedeixi apreciar-ne també els riscos que li són propis, com poden ser, des d’un punt de vista específic, les notícies falses que es poden crear a partir de les solucions d’IA, els resultats esbiaixats o, des d’una perspectiva més general, el risc per a molts dels nostres drets i llibertats.

Aquestes amenaces en alguns casos ja s’han materialitzat, sigui a través de sistemes complexos –com el del crèdit social implantat a la Xina–, o mitjançant aplicacions més senzilles –els sistemes de recomanació de contingut digital que pot donar lloc a una bombolla de filtres o els sistemes de publicitat personalitzada que poden condicionar el resultat d’eleccions polítiques, com va fer evident el cas de Cambridge Analytica.

La Xina fa un ús molt invasiu de la IA per controlar la població. El conegut sistema de crèdit social aplica una vigilància massiva (tant en línia com a la via pública amb càmeres que utilitzen reconeixement facial). De la perfilació de les persones es deriva una puntuació que s’utilitzarà per premiar o per castigar -per exemple, el teu crèdit social pot determinar si pots viatjar, si tens accés a certes escoles o universitats, etc.

Els sistemes de recomanació han estat un gran èxit comercial. Per exemple, s'usen en les plataformes de vídeo per recomanar-te pel·lícules o en una botiga en línia per recomanar-te determinats articles de consum. Tot i que aquests usos no presenten gaires problemes, és clar que limiten les possibilitats d’elecció de les persones, ja que, en ser presentades amb unes opcions més destacades, els estan guiant cap a aquestes. L’objectiu és obvi: incrementar el consum.

No obstant això, hi ha usos dels sistemes de recomanació que són especialment problemàtics; per exemple, l'ús en la recomanació de notícies. Actualment, una gran part de la població accedeix a les notícies virtualment, de manera que és possible mostrar un contingut diferent de cadascú en funció del seu perfil. Ara bé, quan aquesta personalització és massa intensa, pot ser que a aquesta persona només li presentin una part de la realitat, probablement la que s’ajusta més a la seva manera de pensar, de manera que és possible que acabi radicalitzant-la (ja que ni tan sols entra en contacte amb visions alternatives).

El 2014, Cambridge Analytica va recollir dades de milions de persones sense el seu consentiment i les va utilitzar per donar suport a la campanya electoral de Trump.

Les dades es van recollir a través de l’app This is your digital life. En principi aquesta era una app que permetia respondre a un qüestionari que s’utilitzaria amb finalitats acadèmiques. Es van pagar unes desenes de milers de persones per fer el qüestionari. En realitat, l’app va recollir la informació del perfil no només d’aquestes persones, sinó també dels seus amics, de manera que va donar lloc a una violació de la privacitat que va afectar més de 80 milions de persones.

Les dades es van utilitzar a la campanya electoral de Trump per personalitzar la publicitat electoral que es feia arribar a cada elector potencial, fent èmfasi en les coses que, segons el seu perfil, podien preocupar més a cadascú.

La primera notícia del que va acabar sent un escàndol va aparèixer al diari britànic The Guardian al final del 2015. Més endavant, el 2018, un extreballador de Cambridge Analytica va revelar els detalls del cas.

Facebook va ser conscient de la filtració massiva de dades des del 2015, però no va fer res per mitigar els riscos que se'n van derivar. El cas va acabar amb la imposició d’una multa milionària per a Facebook i amb la desaparició de Cambridge Analytica.

En tot cas, Cambridge Analytica no és l'única empresa que feia publicitat dirigida en funció del perfil psicològic de les persones. Va ser la magnitud de l’assumpte el que va fer que el cas de Cambridge Analytica captés l’atenció mediàtica en l'àmbit internacional.

Així doncs, tot i l’enorme potencial positiu que pot derivar de l’adopció de tecnologies emergents i de la IA, cal ser molt prudent a l'hora d'implementar-les i sempre considerar-ne els riscos significatius que pot implicar en relació amb el conjunt de drets i llibertats dels ciutadans, que, només a partir dels tres exemples citats, ja s’observa que podrien afectar drets tan essencials com la llibertat d’informació, la democràcia o la pròpia llibertat de les persones en el sentit més ampli del terme.

Aquesta prudència requereix valorar de manera crítica i detinguda l’adopció d’aquestes tecnologies i també adoptar mesures de protecció adequades. Entre les mesures de protecció destaca la preservació de les dades personals, ja que, tal com s’indicava a l’inici d’aquest apartat, les dades són un input essencial de la IA. Així mateix, cal tenir present que darrere de cada dada personal hi ha sempre una persona.

En definitiva, les teves dades són els teus drets. Protegir-les implica preservar el conjunt de drets i llibertats, ja que necessàriament limita l’impacte negatiu que pot comportar la implantació de les tecnologies emergents com és la IA.

Com a primer pas per aconseguir una protecció adequada, és especialment útil estar al dia de les novetats de la regulació de les tecnologies emergents i en particular de la IA, com ara la que es deriva del RIA i la seva intersecció amb el RGPD, les principals decisions –com les que publica el Comitè Europeu de Protecció de Dades–, així com les guies o els treballs que confeccionen el Supervisor Europeu de Protecció de Dades o les diferents autoritats de protecció de dades com l'anglesa o la catalana.